使用Canal同步MySQL的数据可以直接使用Canal客户端API方式消费Canal同步的数据,详细api参照:

ClientAPI · alibaba/canal Wiki · GitHub

也可以直接通过Canal将数据写入Kafka。下面我们使用Canal同步MySQL数据到Kafka为例,学习下Canal如何同步MySQL数据。

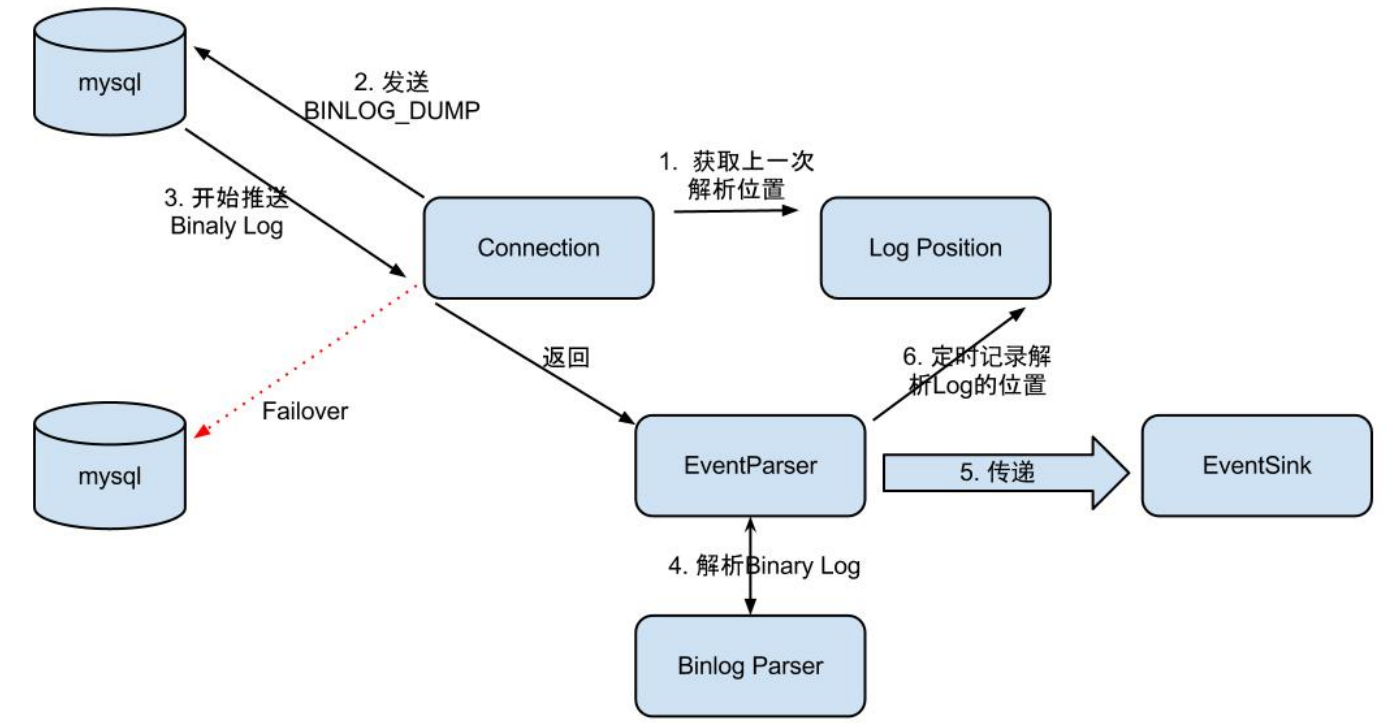

EventParser在向mysql发送dump命令之前会先从Log Position中获取上次解析成功的位置(如果是第一次启动,则获取初始指定位置或者当前数据段binlog位点)。mysql接受到dump命令后,由EventParser从mysql上pull binlog数据进行解析并传递给EventSink(传递给EventSink模块进行数据存储,是一个阻塞操作,直到存储成功),传送成功之后更新Log Position。流程图如下:

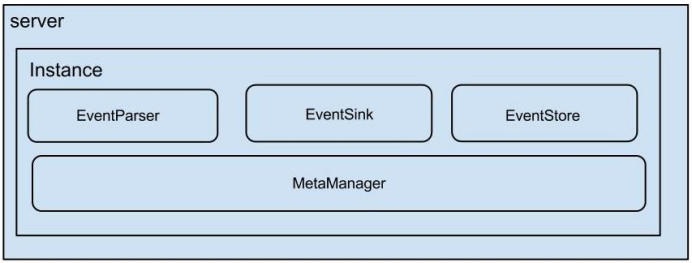

EventSink起到一个类似channel的功能,可以对数据进行过滤、分发/路由(1:n)、归并(n:1)和加工。EventSink是连接EventParser和EventStore的桥梁。

EventStore实现模式是内存模式,内存结构为环形队列,由三个指针(Put、Get和Ack)标识数据存储和读取的位置。

MetaManager是增量订阅&消费信息管理器,增量订阅和消费之间的协议包括get/ack/rollback,分别为:

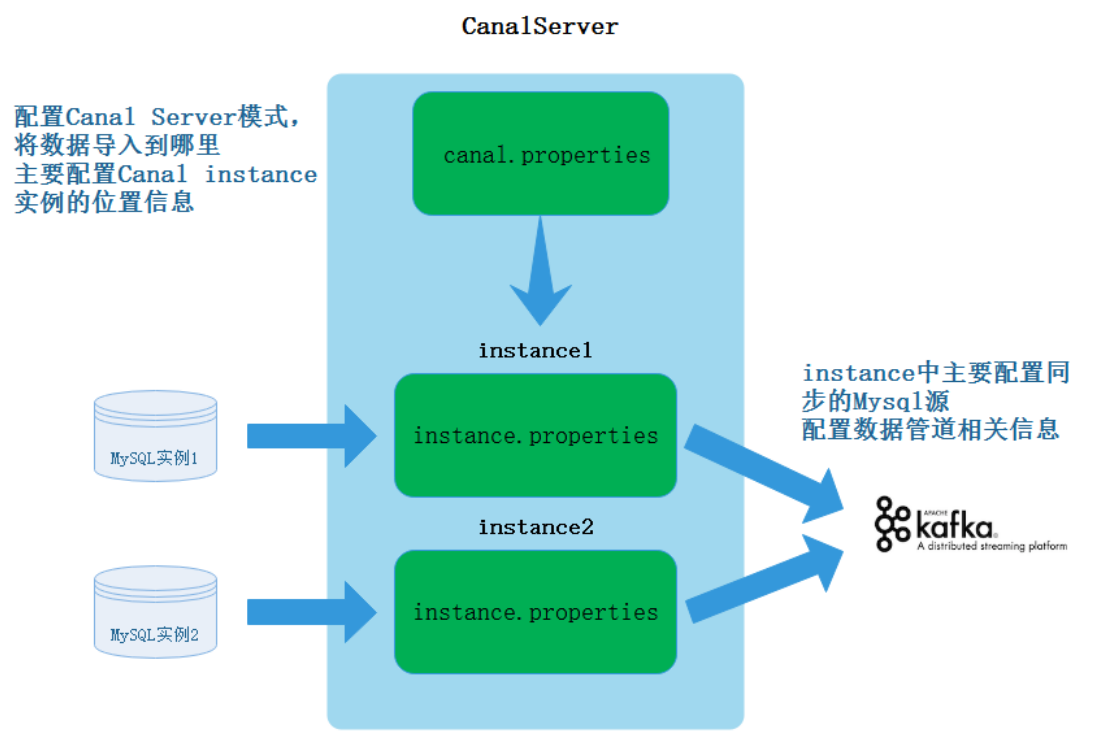

首先Canal可以是一个集群,这里以Canal单机为例解释Canal同步MySQL数据配置文件配置原理。

首先需要在Canal中配置CanalServer 对应的canal.properties,这个文件中主要配置Canal对应的同步数据实例(Canal Instance)位置信息及数据导出的模式,例如:我们需要将某个mysql中的数据同步到Kafka中,那么就可以创建一个“数据同步实例”,导出到Kafka就是一种模式。

其次,需要配置Canal Instance 实例中的instance.properties文件,指定同步到MySQL数据源及管道信息。

进入“/software/canal/conf”目录下,编辑“canal.properties”文件:

#canal将数据写入Kafka,可配:tcp, kafka, RocketMQ,tcp就是使用canal代码接收

canal.serverMode = kafka

#配置canal写入Kafka地址

canal.mq.servers = node1:9092,node2:9092,node3:9092关于canal.properties更多参数参照:

AdminGuide · alibaba/canal Wiki · GitHub

Canal的原理是模拟自己为mysql slave,所以这里一定需要做为mysql slave的相关权限 ,授权Canal连接MySQL具有作为MySQL slave的权限:

mysql> CREATE USER canal IDENTIFIED BY 'canal';

mysql> GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%';

mysql> FLUSH PRIVILEGES;

mysql> show grants for 'canal' ;进入“/software/canal/conf/example/”下,编辑“instance.properties”文件:

#canal伪装为一个mysql的salve,配置其id,不要和真正mysql server-id冲突,这里也可以不配置,会自动生成

canal.instance.mysql.slaveId=123456

#配置mysql master 节点及端口

canal.instance.master.address=node3:3306

#配置连接mysql的用户名和密码,就是前面复制权限的用户名和密码

canal.instance.dbUsername=canal

canal.instance.dbPassword=canal

#配置Canal将数据导入到Kafka topic

canal.mq.topic=canal_topic配置参照:

Canal Kafka RocketMQ QuickStart · alibaba/canal Wiki · GitHub

关于“instance.properties”更多参数介绍如下:AdminGuide · alibaba/canal Wiki · GitHub

进入“/software/canal/bin”,执行“startup.sh”脚本启动Canal。

#启动Canal

[root@node3 ~]# cd /software/canal/bin/

[root@node3 bin]# ./startup.sh

[root@node3 bin]# jps

68675 CanalLauncher #启动成功注意:“canal_topic”不需要提前创建,默认创建就是1个分区。

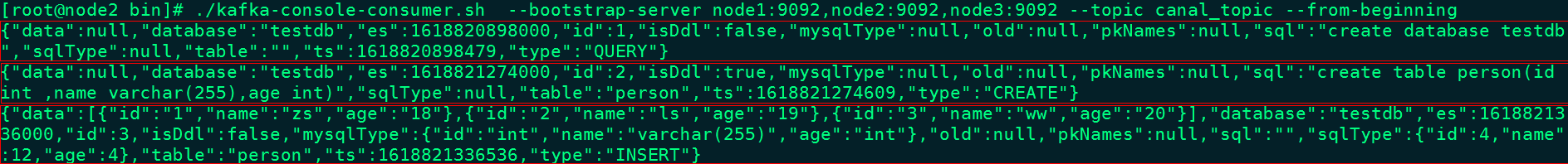

[root@node2 bin]# ./kafka-console-consumer.sh --bootstrap-server node1:9092,node2:9092,node3:9092 --topic canal_topicmysql> create database testdb;

mysql> use testdb;

mysql> create table person(id int ,name varchar(255),age int);

mysql> insert into person values (1,"zs",18),(2,"ls",19),(3,"ww",20);对应的在Kafka中有对应的数据日志写入

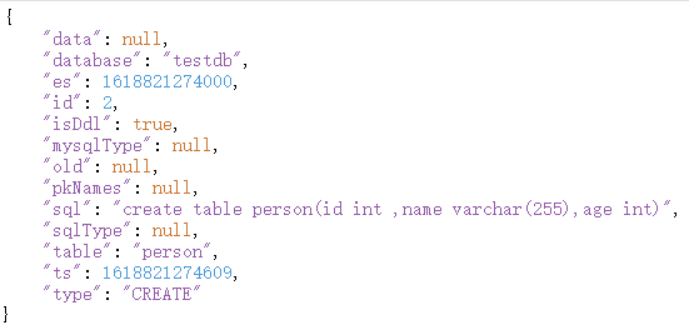

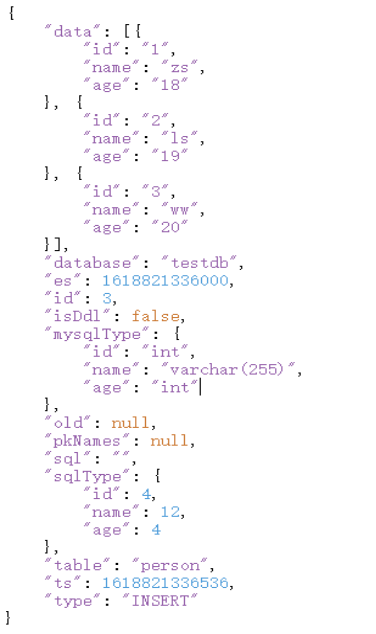

以上写入Kafka中json格式如下:

关于以上json字段解析如下: