最近几年,中国的开源技术和开源社区步入了发展的快车道,其主客观的原因很多,包括:

各种开源项目和社区为加速创新和软件开发的项目做出贡献。从操作系统和框架到数据技术、自动化工具和编程语言,开源软件无处不在,并嵌入到我们最关键的基础设施系统和经济部门中。

《2023 年开源技术报告》是 Perforce 的 OpenLogic 与开源倡议 (OSI) 之间的合作,阐明了开源软件如何以及为何越来越多地被各种规模的组织所采用。根据来自全球 20 个不同行业的用户的调查反馈,该报告提供了当前开源的清晰快照,包括团队需要解决的支持挑战,以通过 OSS 获得长期成功。

本文中,我们截取开源技术中的数据技术篇,向大家展示在开源领域最受欢迎的大数据技术是哪些,在每个行业中的应用情况,以及企业用户在使用中的痛点。

在我们的数字时代,数据为王,而更好地管理数据的需要导致了开源数据技术的激增,技术的扩散。这些技术远远超出了传统数据库的能力。今天的数据技术涵盖了流处理、高效创建分析的功能,内存数据库,面向对象的格式,以及各种集成的的能力。

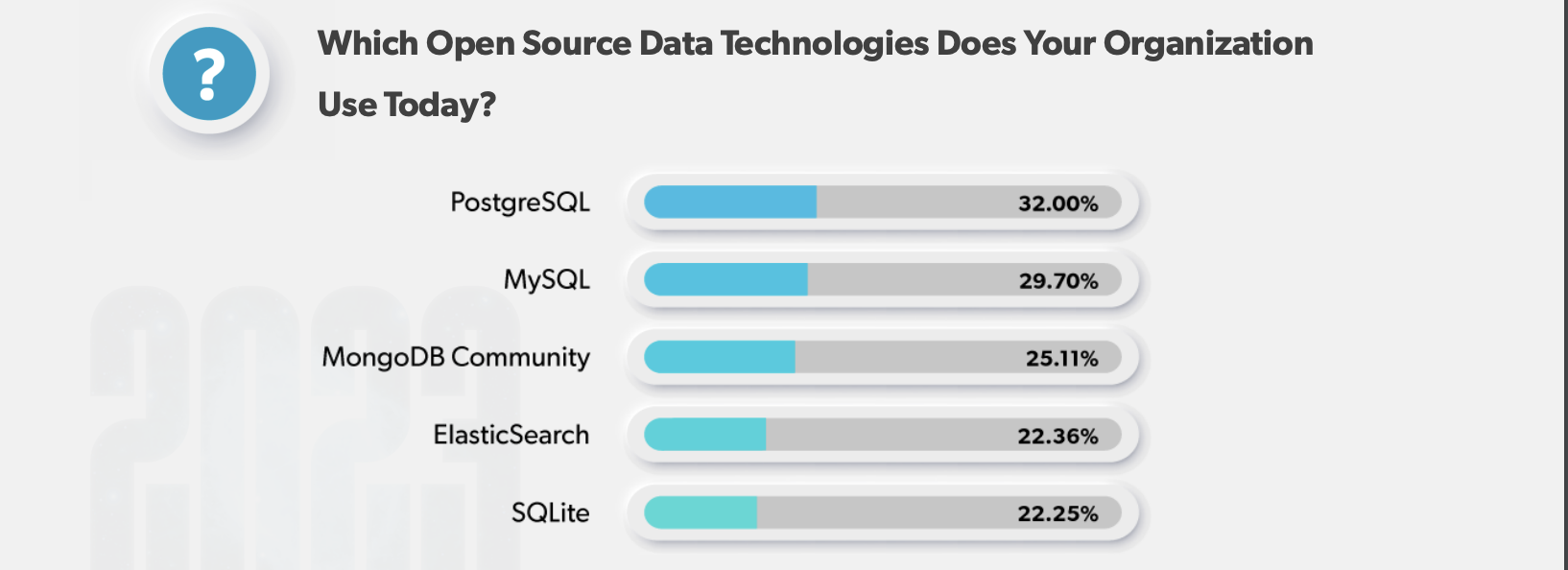

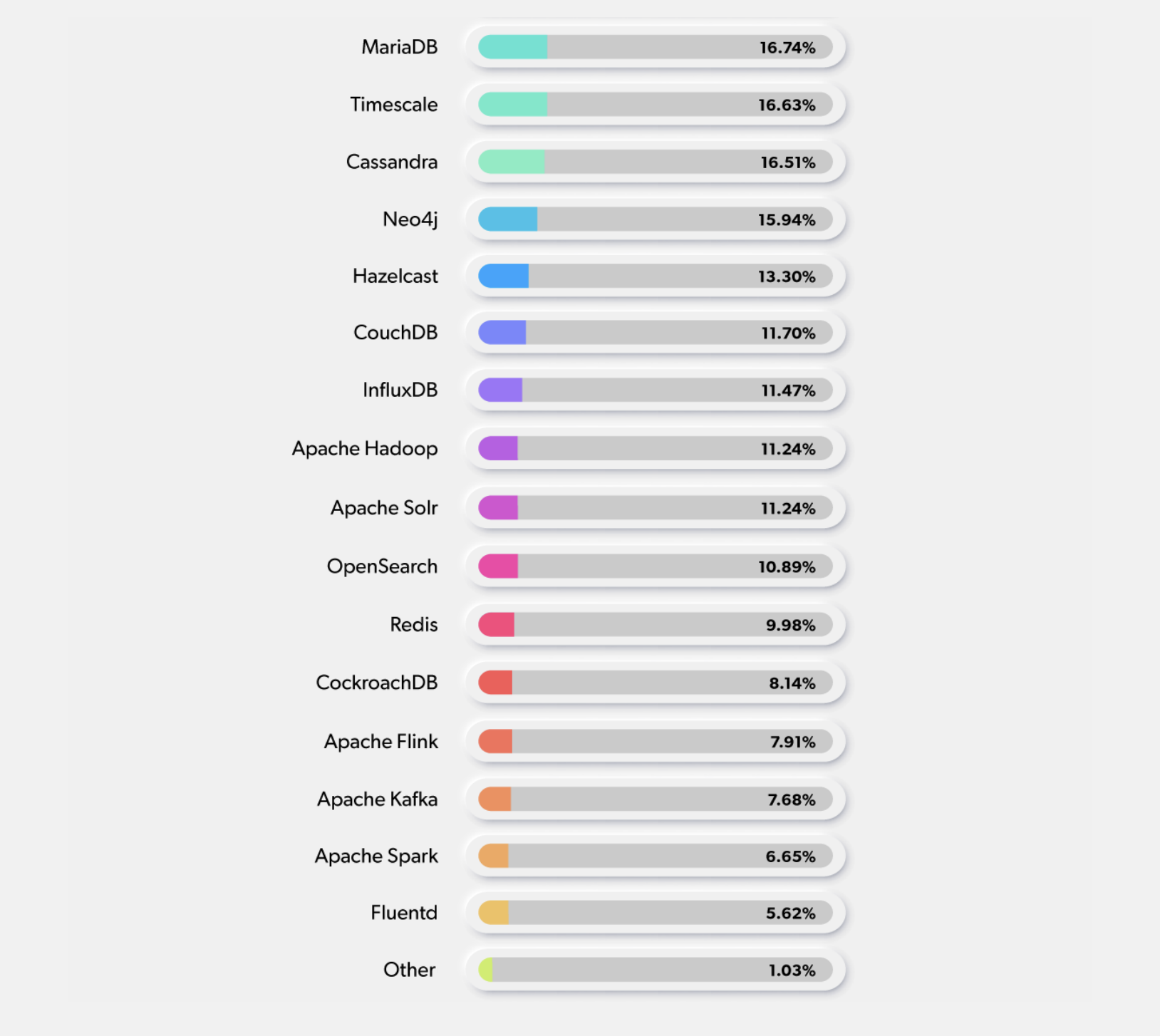

我们允许受访者选择多个答案,以反映他们组织中使用的所有不同的数据技术。

与过去几年一致,使用最多的数据技术是数据技术是PostgreSQL、MySQL、MongoDB和Elasticsearch。

今年的惊喜是,MySQL和PostgreSQL的位置互换了几个百分点。几个百分点,现在PostgreSQL是使用最多的数据技术。

去年,PostgreSQL超过MongoDB升至第二位,所以看到过去两年中使用量的增长很有意思。

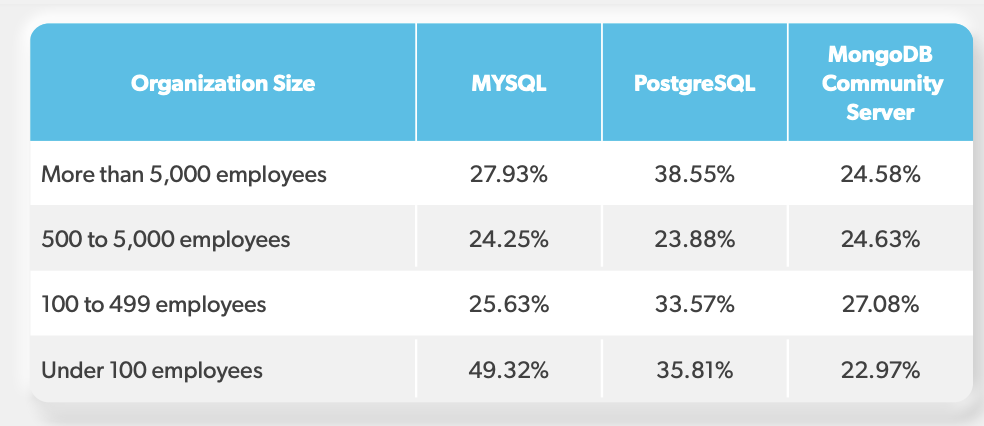

按照组织的规模来研究使用最多的开源数据技术总是很有启发性的。

与去年相比,我们看到MySQL和MongoDB Community Sever的使用量减少了,而PostgreSQL的使用量增加了,特别是在大型组织。PostgreSQL,特别是对于大型组织。然而,对于员工少于100人的小型组织,MySQL 使用量比去年增加了9%。

人工智能/ML应用在很大程度上驱动了对开源数据技术的使用增长,因为人工智能/ML模型

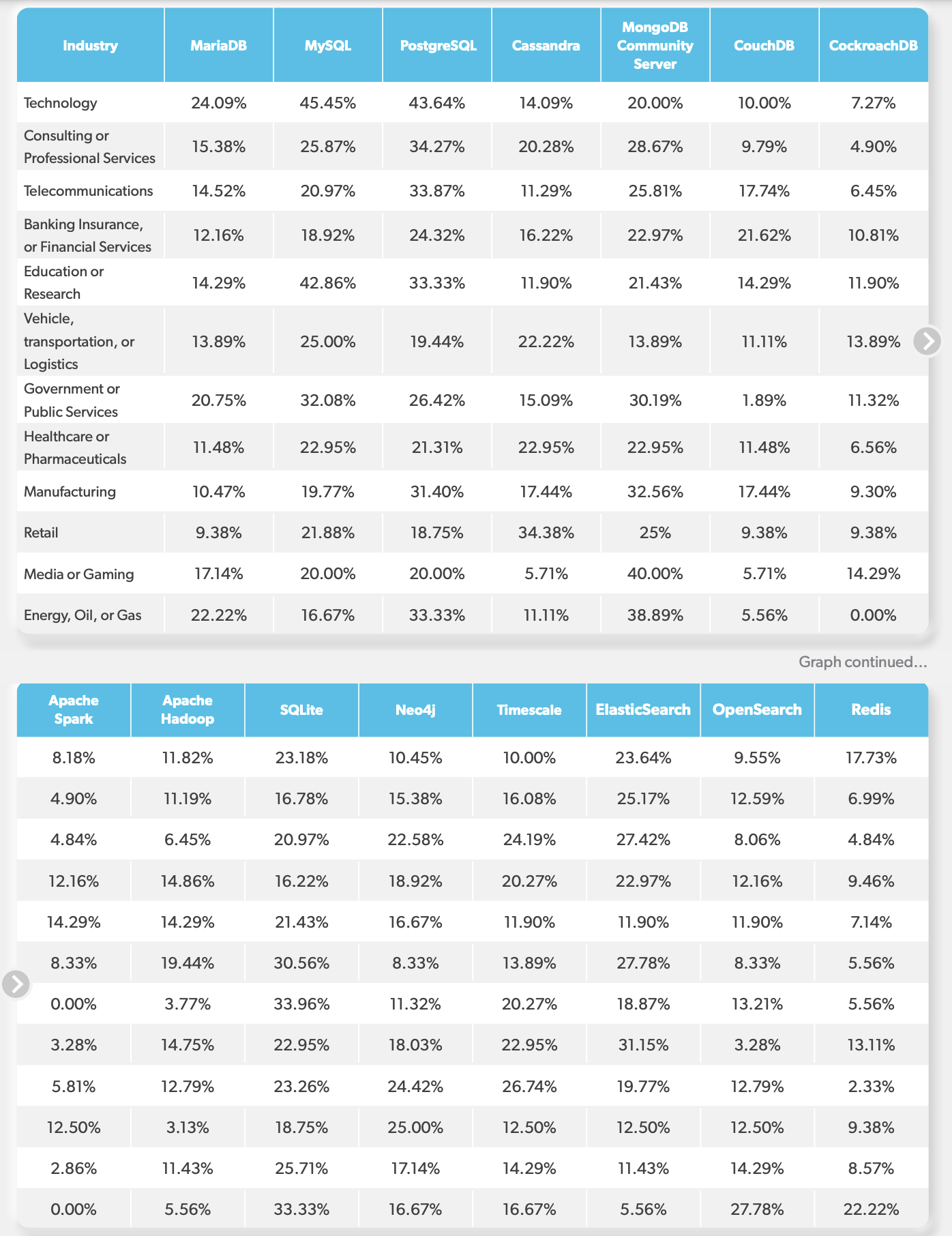

是通过大量的数据来训练的。下图显示,一些行业继续使用基于SQL的数据库。

而其他行业正在多样化地使用开源数据技术。例如,Apache Spark、Apache Cassandra。

ElasticSearch和OpenSearch正被用于许多AI/ML解决方案。

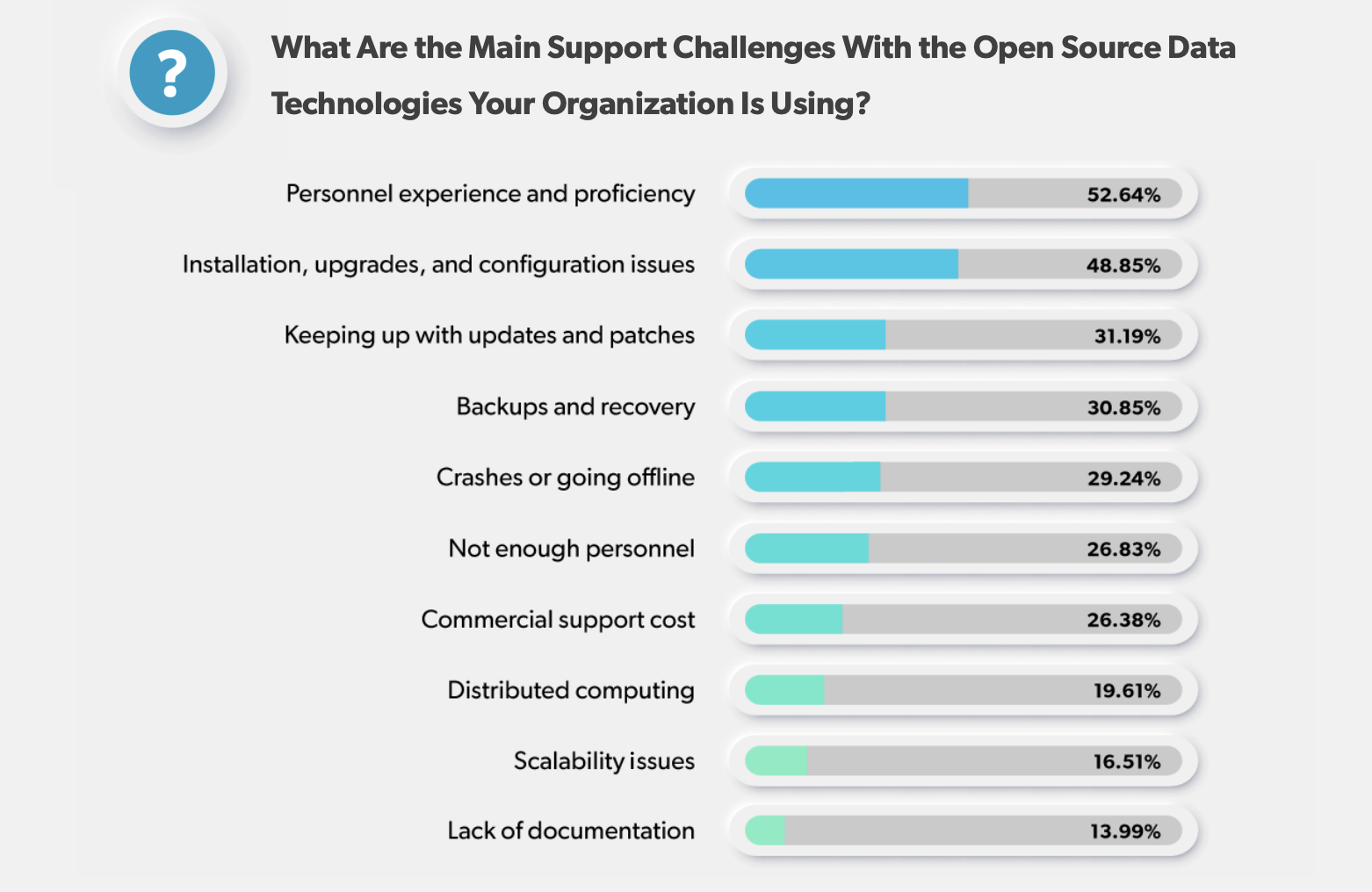

在这一类别中,人员经验和熟练程度的问题超过了安装、升级和配置的问题。

幅度约为4%(52.64%对48.85%)。这充分说明了对这些复杂数据技术的技能需求。即使你部署的是稳定的、成熟的工具,拥有庞大的贡献者群体,也可能出错。这就是这就是为什么那些了解数据技术并在上游为开放源码做出贡献的专家会有很大的需求。

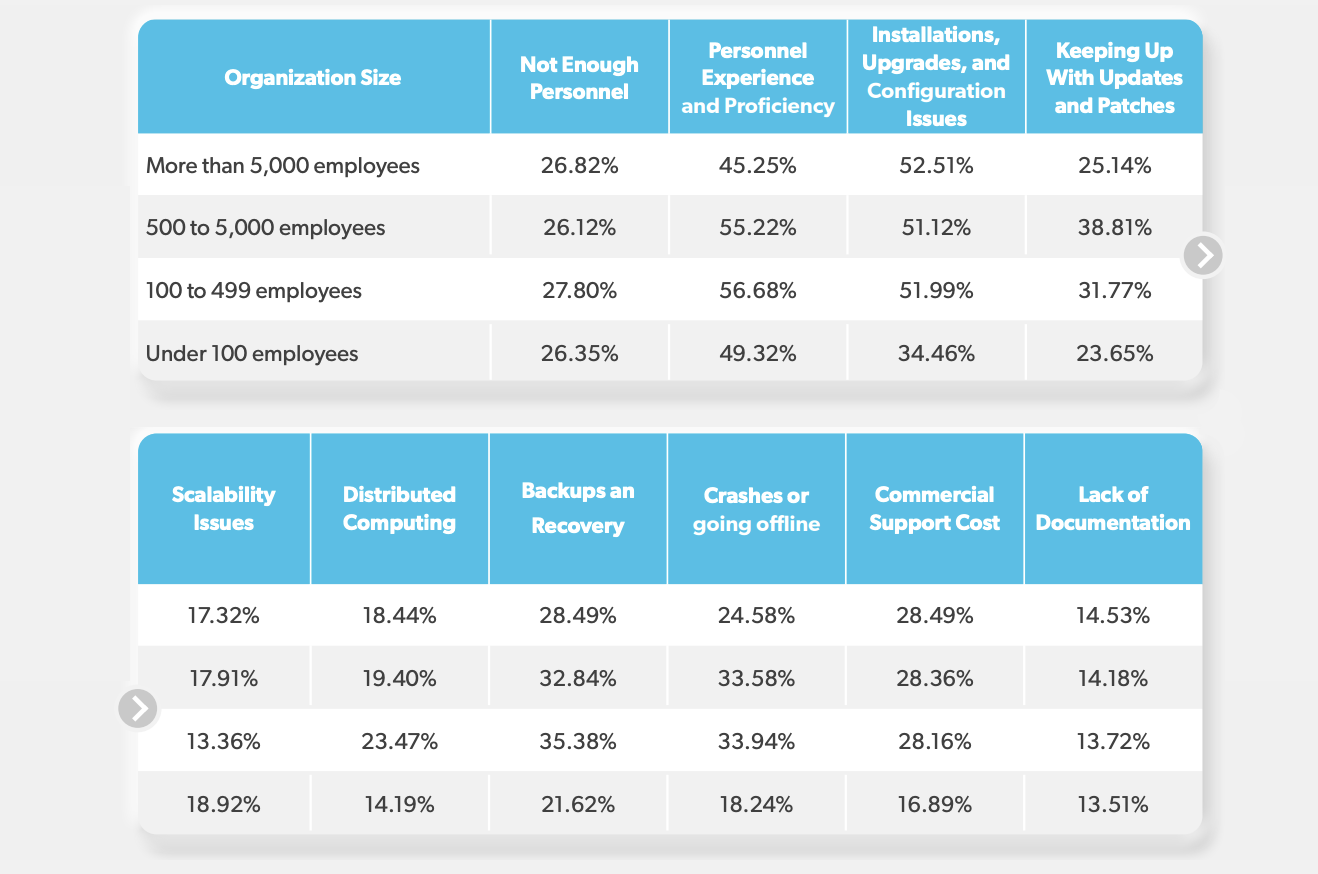

为包括技术支持在内的商业开源软件付费是一种选择,但会带来较高的价格成本和厂商锁定。组织的规模在这里起了作用,因为超过28%的大中型企业的受访者将商业支持成本列为挑战,而小型组织的受访者只有17%。这可能是因为小型组织正在使用社区开源版本,而不是为商业支持付费。

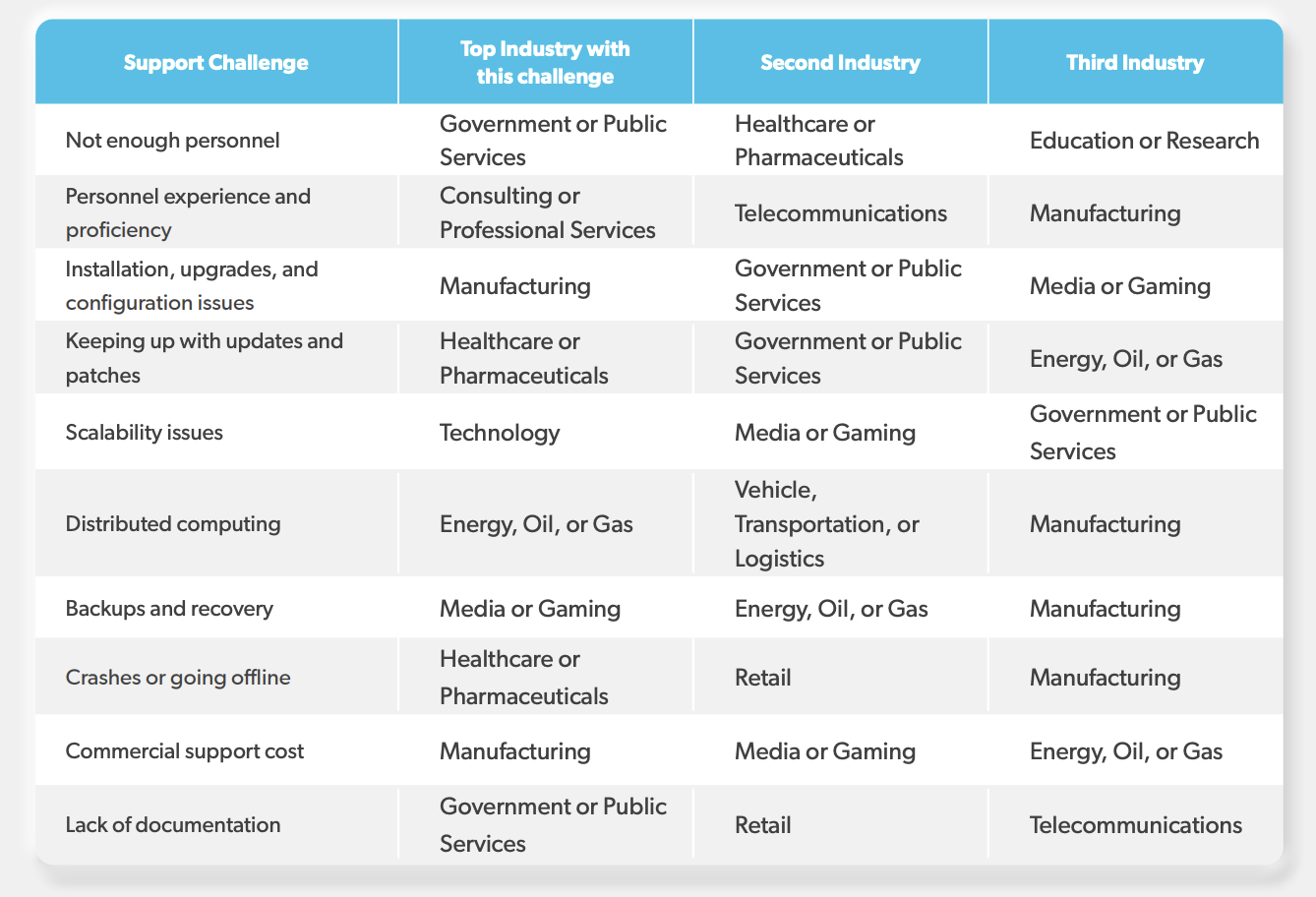

而如果按照行业进行划分,在技术支持方面,不同行业的需求会有不同:

使用开源技术是一个明智的选择,能够帮助我们更快,更轻松地通过构建技术支撑,达成商业目的。但是在使用的过程中,我们需要具备以下的认知:

首先,使用开源技术并不代表零成本。在建设、维护和升级方面,都需要持续的投入,不仅包括技术方面的投入,还需要考虑到人员、技能和咨询等方面的投入。

其次,在选择适合的技术之前,需要制定相应的规划,以确保从开源技术的使用中获得利益。这个规划需要包括对技术本身的了解,对使用过程中可能出现的问题的预期,以及对使用过程中需要的支持和咨询的预算等方面的考虑。

最后,需要认识到开源技术在不断发展和改进,因此需要持续关注和学习,以确保在使用过程中能够获得最大的效益。

总之,使用开源技术是一个不错的选择,但是需要认真思考并做好规划和投入,才能在实际应用中获得成功。